|

|

前言:本篇的一些內(nèi)容比較的有意思,總結(jié)了可能平時大家可以注意到的一些優(yōu)化點,而且非常的實用。

本篇的議題如下:

識別和分析服務(wù)端的性能瓶頸(上)

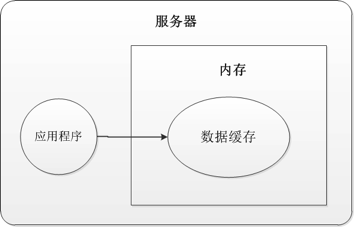

內(nèi)存(前篇)

緩存(前篇)

CPU(后篇)

處理請求線程(后篇)

提高性能的一些簡單改進(jìn)措施(下)

部署優(yōu)化(前篇)

減少不必要回傳(前篇)

減少不必要的請求(后篇)

搜索引擎問題

熱鏈接問題

驗證碼(CAPTCHA)

服務(wù)端的要處理的請求越多,無疑服務(wù)端的壓力也就越大,尤其是有些請求需要訪問一些比較昂貴的資源,例如數(shù)據(jù)庫,服務(wù)端的文件等。但是我們必須知道,在到達(dá)服務(wù)端的請求中,有些請求時我們希望的,例如網(wǎng)站的用戶的請求,有些請求其實是不必要,甚至是我們不想要的,為此,我們要避免這樣的請求,節(jié)省服務(wù)端的資源,從而提高性能。

搜索引擎

首先來看看有關(guān)搜索引擎的問題。

然后搜索引擎爬到我們的站點是一件好的事情,很多的SEO可以進(jìn)行,推廣站點。同時,在站點中,有些文件或者資源比較的私密,或者我們不希望被搜索引擎請求和收錄的,因為每次搜索引擎在請求這些資源的時候,就是發(fā)送請求到我們的站點服務(wù)器,勢必會加重服務(wù)器的負(fù)載。

不需要被搜索引擎請求的文件一般如下:

1. 圖片資源

2. Js腳本,css等

3. 一些需要身份驗證或者授權(quán)才能看的頁面(如果頁面需要驗證之后才能看,搜索引擎收錄了也作用不大)

我們可以設(shè)置一下,告訴搜索引擎的蜘蛛程序如何爬我們的站點。

步驟如下:

1. 在站點的根目錄下面,創(chuàng)建一個robots.txt的文件。

2. 寫入文件。如果我們希望阻止所有的搜索引擎來爬我們的站點的頁面,那么就可以在文件中寫入下面的配置:

User-agent: *

Disallow: /

如果希望阻止搜索引擎爬某個文件夾,可以配置如下:

User-agent: *

Disallow: /images/

Disallow: /js/

Disallow: /css/

Disallow: /private/

更有趣的是:對于某些搜索引擎,我們還可以改變他們的蜘蛛程序爬我們站點的頻率,設(shè)置如下:

User-agent: *

Crawl-delay: 10

大家可以去上網(wǎng)找下一些如何影響Google,百度等蜘蛛程序的設(shè)置。

熱鏈接問題

就是在A網(wǎng)站上面顯示一個來自B網(wǎng)站的圖片鏈接。例如我們在自己的站點上面有一個鏈接如下:img src=http://www.xxx.com/yyy.gif/,那么在別人在瀏覽我們的站點的時候,就回去別人的那個站點(http://www.xxx.com/yyy.gif)去請求這個圖片,那么勢必會消耗他們的服務(wù)器的資源。發(fā)過來,如果別人在他們的站點上采用了我們的圖片或者其他的鏈接資料,那么用戶在瀏覽別人的站點的時候就會消耗我們站點的服務(wù)端資源和帶寬。

為一個組件就可以阻止這種情況的發(fā)生:http://www.iis.NET/community/default.

ASPx?tabid=34i=1288g=6.大家去看看。

驗證碼(CAPTCHA)

我們常常在站點中加入一些驗證碼的功能來防止網(wǎng)絡(luò)注冊機(jī)。一般是生成一張有文字的圖片,然后根據(jù)驗證用戶輸入的文字和圖片中的文字是否一樣來判斷此時的用戶是人還是注冊機(jī)。

通過驗證碼阻止了注冊機(jī)隨意的消耗站點資源(如果沒有驗證碼,注冊機(jī)可以不斷的注冊信息,大小服務(wù)器和數(shù)據(jù)庫資源,而且產(chǎn)生很多的垃圾數(shù)據(jù))。

我們自己寫生成驗證碼的程序,一般通過GDI+來做,同時也可以采用一些第三方的庫實現(xiàn),例如:reCAPTCHA: http://recaptcha.NET/,大家上網(wǎng)找下,很多的。

網(wǎng)絡(luò)刮刀(Scrapers)與Dos

這個問題必須引起重視。如果我們的站點上面有很多的有用的信息,那么別人可能就可能開發(fā)一個程序來到我們的站點抓取信息,然后把這些內(nèi)容放到自己的站點上面。例如,很多的內(nèi)容型的站點每天都從博客園的首頁上面來抓取信息,然后放到他們的站點上,增加他們的訪問量。

本來站點被搜索引擎抓就有點消耗性能了,如果還被很多的這樣的網(wǎng)絡(luò)刮刀來抓內(nèi)容,對站點的性能影響可想而知。

如果那些網(wǎng)絡(luò)刮刀程序的的IP地址變化不頻繁,而且請求我們站點的頻率比較的由規(guī)律,那么我們就可以采用一些代碼的方式來防止這樣的請求。例如,我們可以監(jiān)測:同一個IP是否在20min之內(nèi)發(fā)送了100個請求,如果是,我們就推測:可能是別人在抓我們的站點內(nèi)容,我們就拒絕這個IP的請求。

當(dāng)然了,上面只是一些簡單的方法,對于一些復(fù)雜的Dos攻擊,上面的監(jiān)測代碼基本沒有作用。因為Dos攻擊中,攻擊的IP地址是變化的。

下面我們就寫一些代碼來防止簡單的網(wǎng)絡(luò)刮刀程序和簡單的Dos攻擊。基本的思想就是:如果在給定的時間段內(nèi),如果某個用戶的請求很多,超過了一定的數(shù)量,那么我們就認(rèn)為這個用戶可能是網(wǎng)絡(luò)刮刀程序,然后就拒絕下面的請求,一段時間之后,再次允許這個從這個IP發(fā)出的請求。

下面的代碼中:假設(shè)如果一個用戶在5秒之內(nèi)發(fā)出了100個請求,那么我們就認(rèn)為這是網(wǎng)絡(luò)刮刀程序或者是網(wǎng)站的攻擊者。當(dāng)然,我們還考慮這個發(fā)送請求的用戶是否是搜索引擎的蜘蛛程序。(下面的代碼只是簡單作為演示,不是實際生產(chǎn)的代碼,拋磚引玉)

1. private const int intervalSeconds = 30;

2. private const int maxRequestsInInterval = 5;

NET技術(shù):構(gòu)建高性能ASP.NET站點之減少不必要的請求,轉(zhuǎn)載需保留來源!

鄭重聲明:本文版權(quán)歸原作者所有,轉(zhuǎn)載文章僅為傳播更多信息之目的,如作者信息標(biāo)記有誤,請第一時間聯(lián)系我們修改或刪除,多謝。